用苹果iMac或者Macbook笔记本玩Windows么?那么这个文章和最新版的BootCamp 5.0.5033下载对你会有帮助。Boot Camp 5 这个新版本并不是4月份刚发的,而是苹果在3月份发布,因为有网友索要,因此特别在IT之家补上。

当买回iMac、Macbook Pro(含 Retina)、Macbook Air 新款电脑和本本后,很多国内消费者习惯性的去安装Win7、Win8。不管你是彻底抹掉Mac OS X分区单装Win7、单装Win8,还是双系统保留Mac OS用Boot Camp来安装第二个系统,你都需要苹果官方最新的驱动程序下载。实际上,在Mac OS里面用Boot Camp来安装Windows 的时候,有一步是提示你下载保存Boot Camp for Windows这个苹果官方驱动包的。一般情况下,软媒小编建议大家关注并下载最新版本的Boot Camp,毕竟每次更新都能解决N多的兼容性问题,尤其是Windows8系统。

微软在2012年正式发布了Windows8正式版,但知道2013年的3月份,苹果才迟迟的推出了为Win8和Win7精心准备的驱动软件套装——BootCamp 5.0.5033 正式版驱动下载。这个版本解决了非常多的大小问题,之前当你使用Mac OS X系统里面自带的BootCamp 4 的驱动的时候,你会发现在Windows8系统里会出现发热厉害、电池表现差、系统不稳定等一些毛病,现在2013年最新版本的BootCamp 5.0 一出,完美的解决了Win8和Win7下因驱动造成的一系列问题,同时,显卡驱动方面的带来了游戏性能的大提升也是非常好的消息。

强烈建议所有安装了 Win8 的 Mac 电脑用户升级 BootCamp,基本上2010年之后的 Macbook Pro、Air、Mini 以及 iMac 均能完美支持 BootCamp 5 以及 Win8,而早于此日期的大多产品只能使用 BootCamp 4 与 Win7 了,苹果将不再提供升级了。新版本的 BootCamp 除了解决了 Win8 驱动的一系列bug之外,显卡驱动的游戏性能也有了不小提升哦……

BootCamp 5.0 版本更新简介:

BootCamp 是苹果电脑的 Windows 驱动程序包的名称,BootCamp 5 主要提供了一系列的关键Bug修正和 Windows 8 系统下的硬件驱动更新,包括最新的 Macbook Pro Retina 视网膜屏幕、雷电接口、USB 3.0、Apple Trackpad触控板及所有主板芯片、WiFi网卡、声卡、蓝牙、键盘输入以及显卡的驱动等。为了你的爱机着想,使用 Mac 安装 Windows 的朋友应该没理由不更新它的。当然如果你不是使用苹果电脑的话可以完全无视这篇文章。

除了支持Win7和Win8系统这一功能之外,Boot Camp 5.0还将可以让用户在他们的Mac机中安装3TB的硬盘驱动。不过,用户在安装之前必须要确保自己的系统已经升级到OS X 10.8.3,Safari已经升级到6.0.3。

BootCamp 5 支持机型与操作系统:

基本上大部分主流的 Mac 电脑都可以升级到 BootCamp 5,包括 MacBook,Mac Mini,MacBook Pro,MacBook Air,iMac 都可以,一些如2009年前及之前的旧型号则不支持,只能安装 BootCamp 4。最简单的判断办法就是,先将 BootCamp 5 下载回去,如果安装时提示错误的话就乖乖去下回 BootCamp 4 吧。而对于操作系统的要求,Win8 和 Win7 下可以装5或4,而在 XP、Vista 下则最高只能安装4。另外 BootCamp 5 只支持64位的系统。

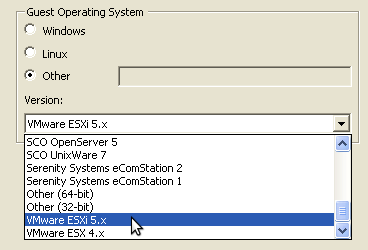

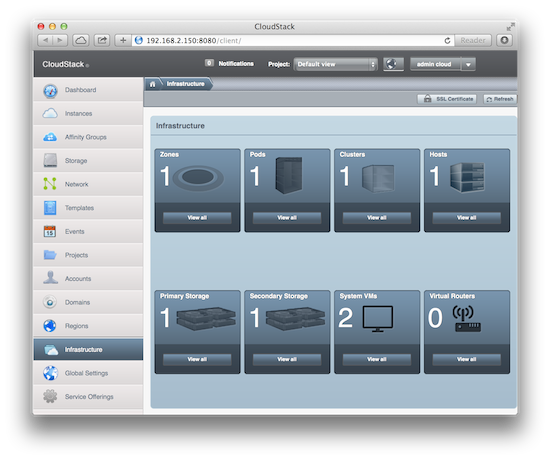

BootCamp 主要用于安装原生的 Windows 系统时使用,如果你使用 Parallels Desktop、VMware Fusion、VirtualBox 等虚拟机软件安装 Windows 的话是不需要安装这个驱动的。

BootCamp 5.0.5033 最新版 for Win7/Win8 下载:

Boot Camp 5 苹果官方网站:http://www.apple.com.cn/support/bootcamp/

Boot Camp 5.0.5033 苹果官方下载(简体中文版):

http://support.apple.com/downloads/DL1638/zh_CN/BootCamp5.0.5033.zip

http://support.apple.com/downloads/DL1638/zh_CN/BootCamp5.0.5033.zip

软件版本:5.0.5033

发布日期:2013-3-14

文件大小:553.62 MB

系統需求: MacBook Air(2011 年中)或更新机型、MacBook Pro(2010 年中)或更新机型、* 不支持 MacBook Pro 13 英寸 - 2010 年中、Mac Pro(2009 年初)或更新机型、Mac mini(2011 年中)或更新机型、iMac(2010 年中或更新机型)、Windows 7 x64、Windows 8 x64

发布日期:2013-3-14

文件大小:553.62 MB

系統需求: MacBook Air(2011 年中)或更新机型、MacBook Pro(2010 年中)或更新机型、* 不支持 MacBook Pro 13 英寸 - 2010 年中、Mac Pro(2009 年初)或更新机型、Mac mini(2011 年中)或更新机型、iMac(2010 年中或更新机型)、Windows 7 x64、Windows 8 x64

软媒再次提示一:BootCamp 5.0 只支持64位的Win7或Win8系统;

软媒再次提示二:2009年前及之前的旧型号苹果Mac电脑则不支持使用BootCamp 5.0,建议依然使用BootCamp 4系列;

BootCamp 5.0.5033 最新版 for Win7/Win8 使用方法:

1、在Win7或Win8系统里将整个 .zip 文件内容解压到您指定存放的地方;

2、运行Boot Camp 文件夹里面的 setup 文件;软媒提醒:如果你抹掉了Mac OS所需的BootCamp隐藏分区,就别运行Setup了,直接找文件夹里面的驱动手动安装就可以了。

3、系统提示允许更改时,点按“是”然后按照屏幕上的说明操作。安装可能需要几分钟。请勿中断安装进程。安装完成后,在出现的对话框中点按“完成”。

4、系统重新启动对话框会出现。点按“是”以完成安装。